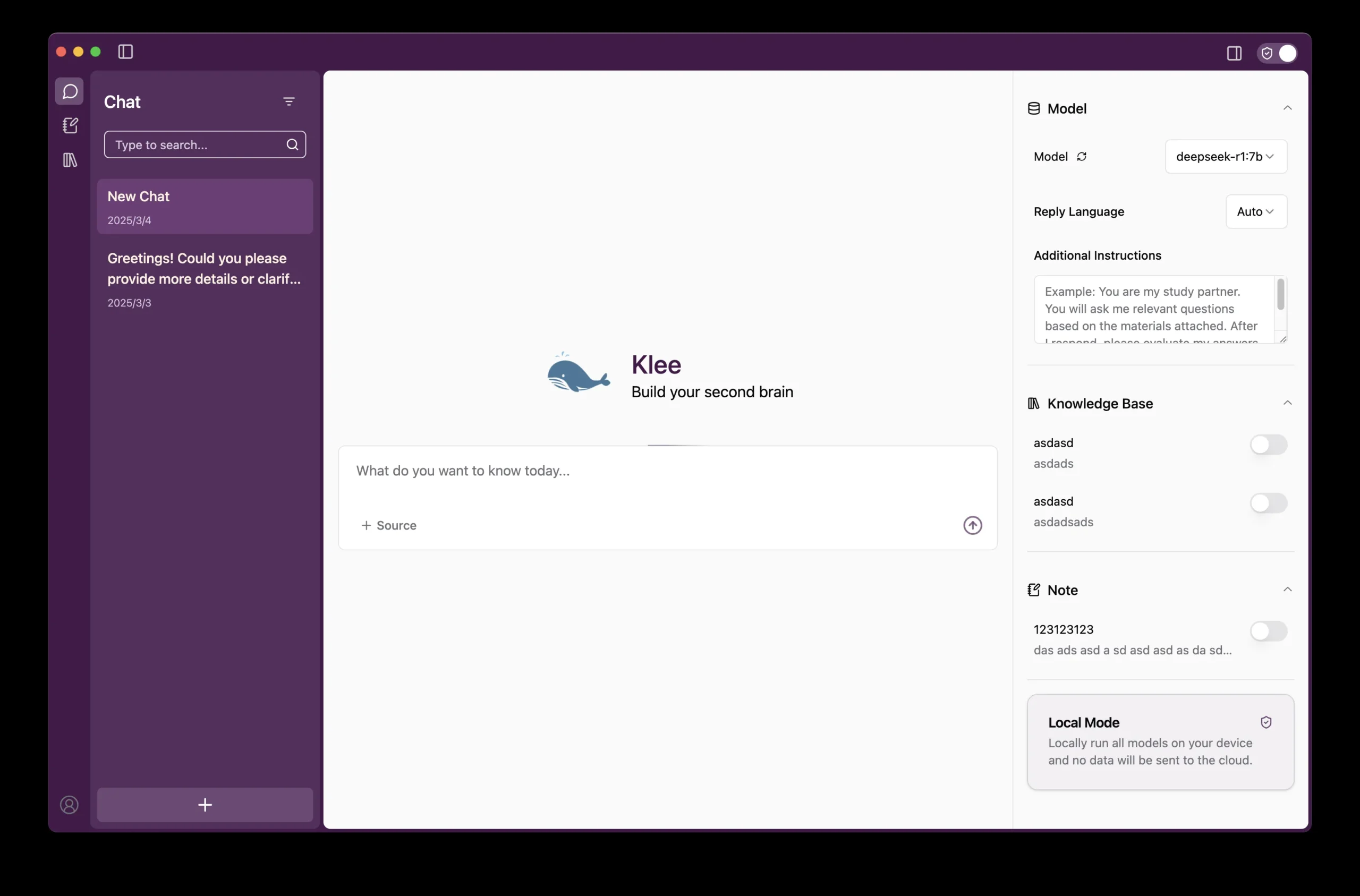

Klee

综合介绍

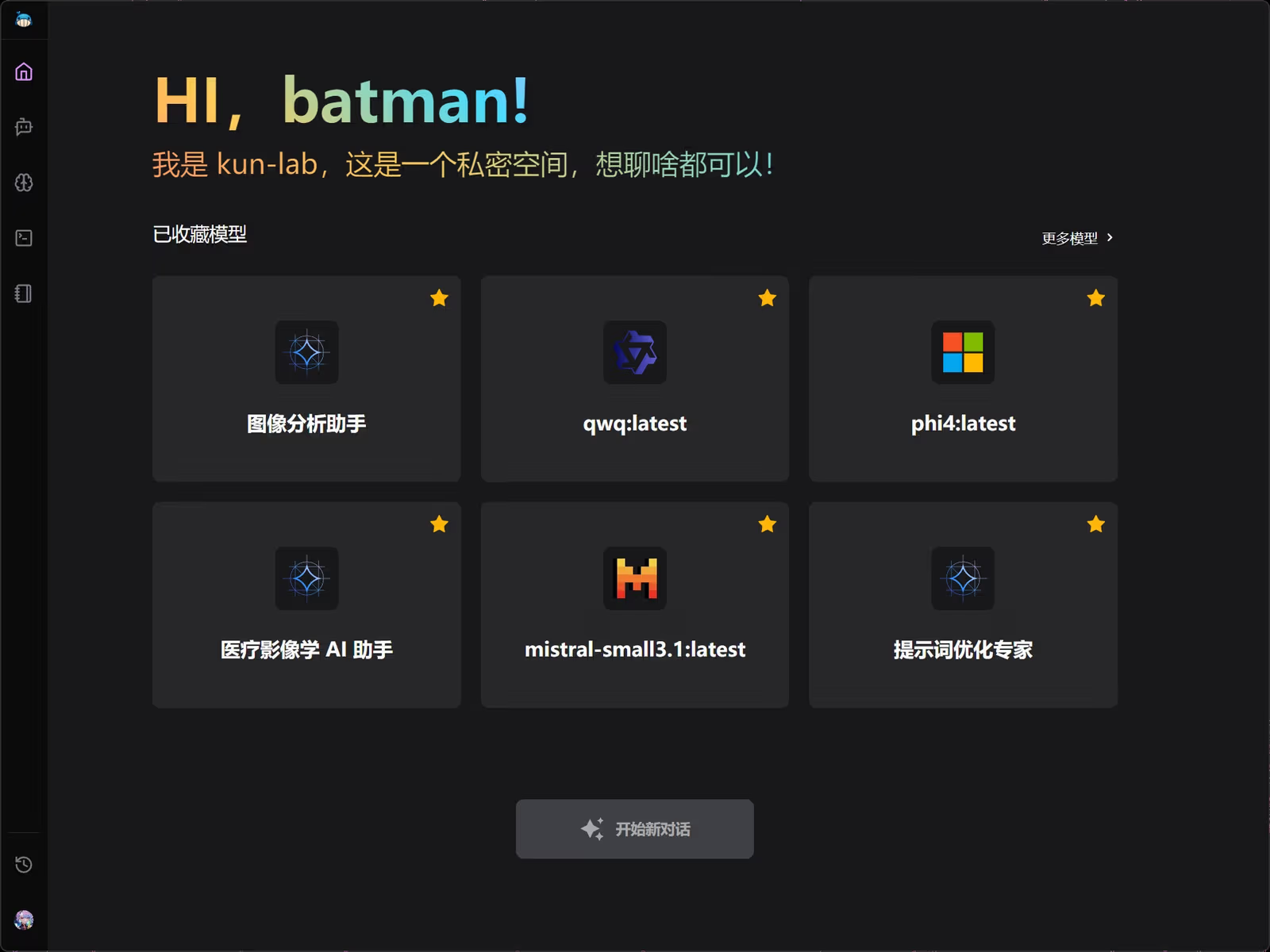

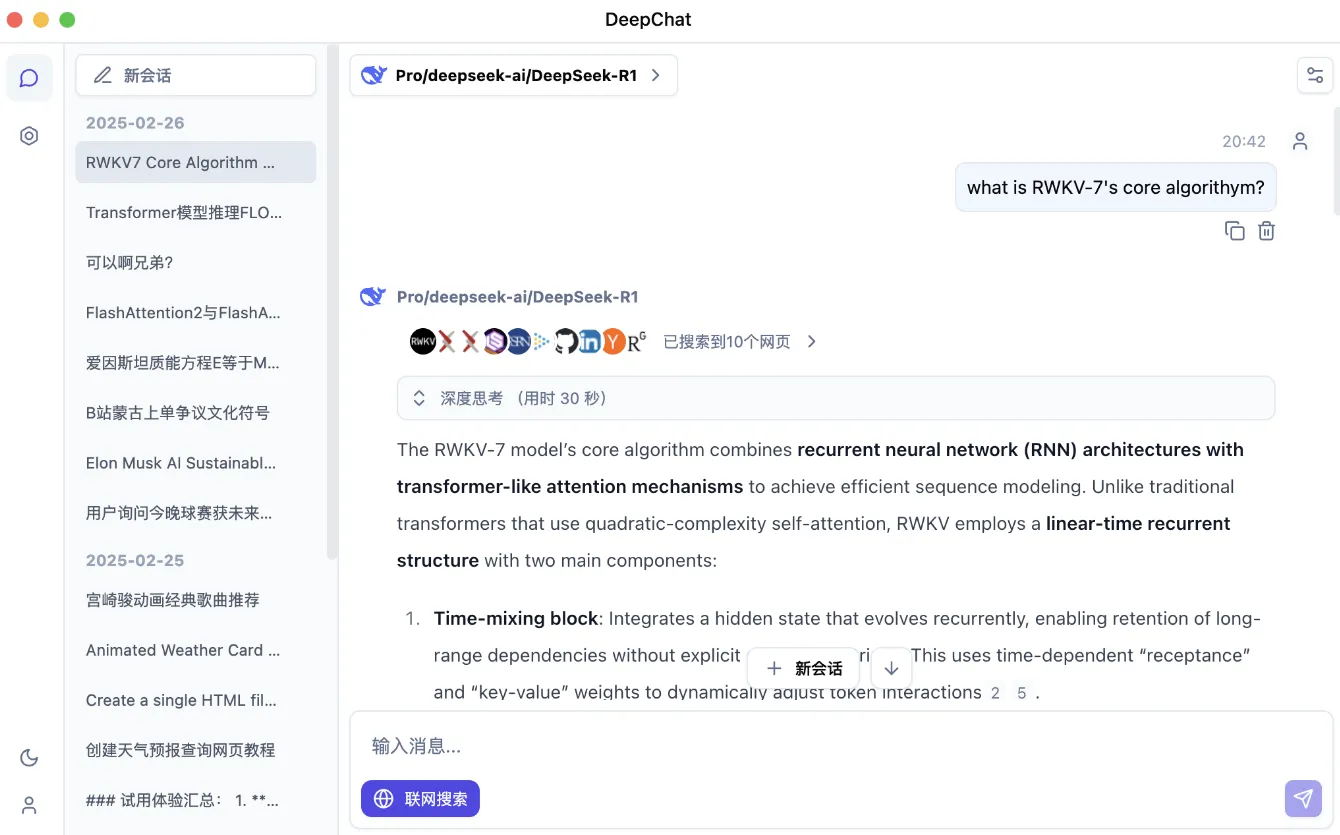

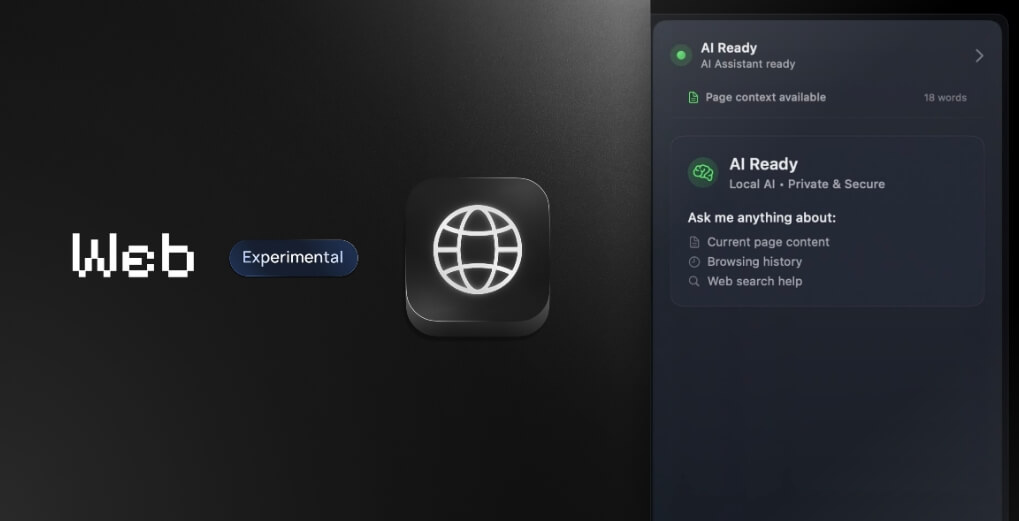

Klee是一款注重数据安全和隐私的桌面AI应用。它允许用户在自己的电脑上本地运行大型语言模型,无需连接互联网,从而确保了所有交互和数据的私密性。该应用内置了一个基于检索增强生成(RAG)技术的知识库,可以读取和处理用户的本地文件,让AI能够根据用户的私有文档内容进行回答和交互。Klee还集成了Markdown笔记功能,方便用户记录和整理AI的输出内容。该软件基于Ollama和LlamaIndex等开源技术构建,旨在为非技术用户提供一个简单易用的本地AI解决方案,只需一键即可下载并运行模型。Klee支持完全本地的私有模式,也提供了连接到云端模型的选项,为用户提供了灵活的选择。

功能列表

- 本地化模型部署:支持通过Ollama在用户自己的电脑上运行开源大型语言模型,确保了数据处理的隐私和安全。

- 无需网络连接:在本地模式下,应用可以完全离线运行,保护用户隐私。

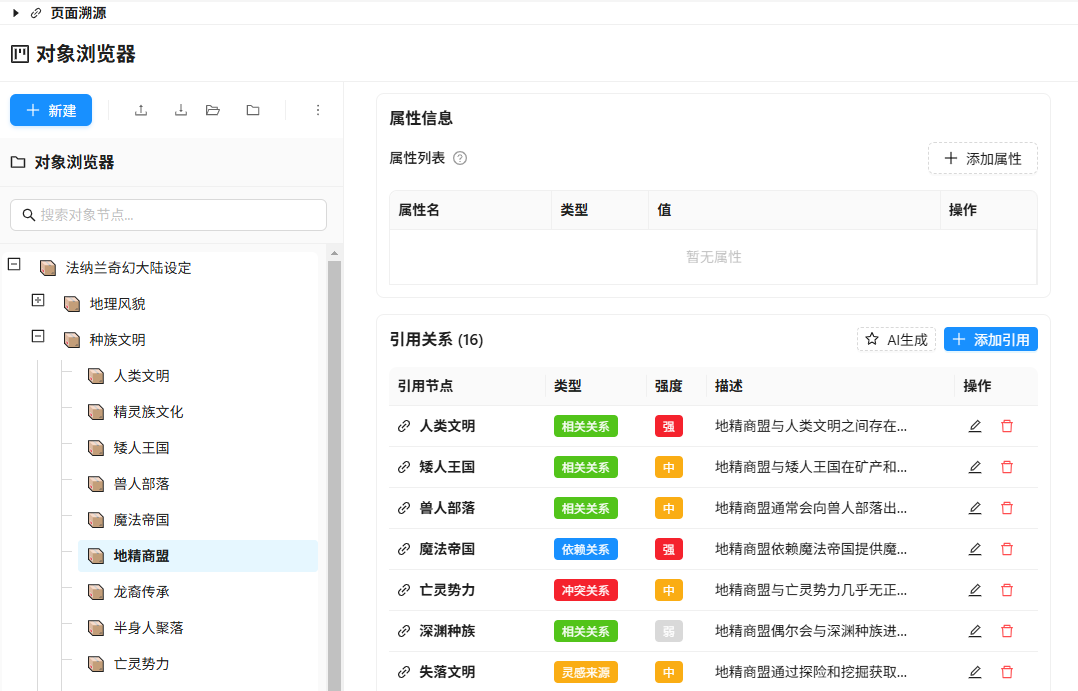

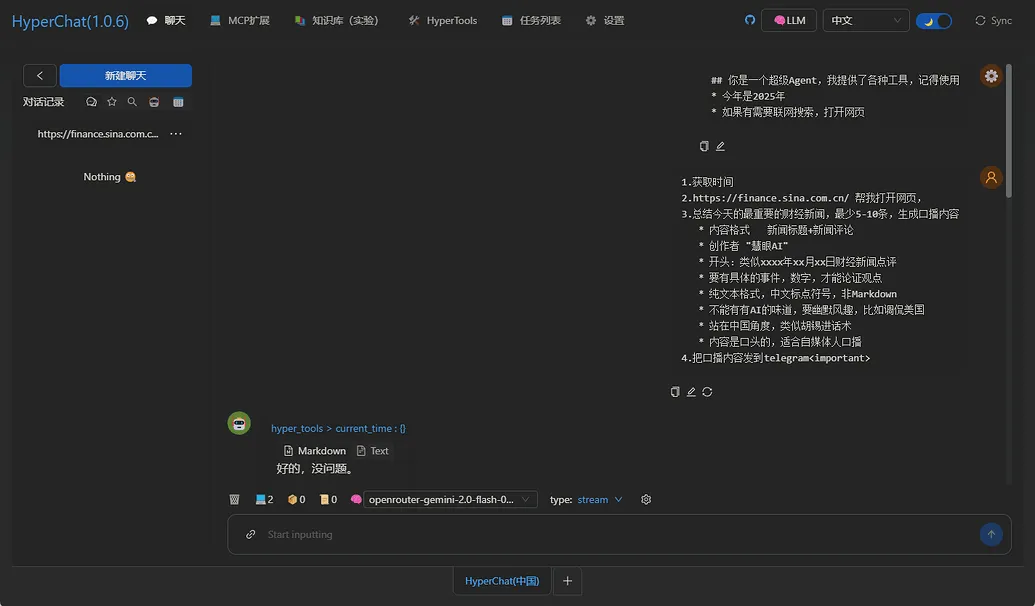

- 内置RAG知识库:集成LlamaIndex框架,可将本地文件和目录作为知识库,让AI根据特定内容进行问答。

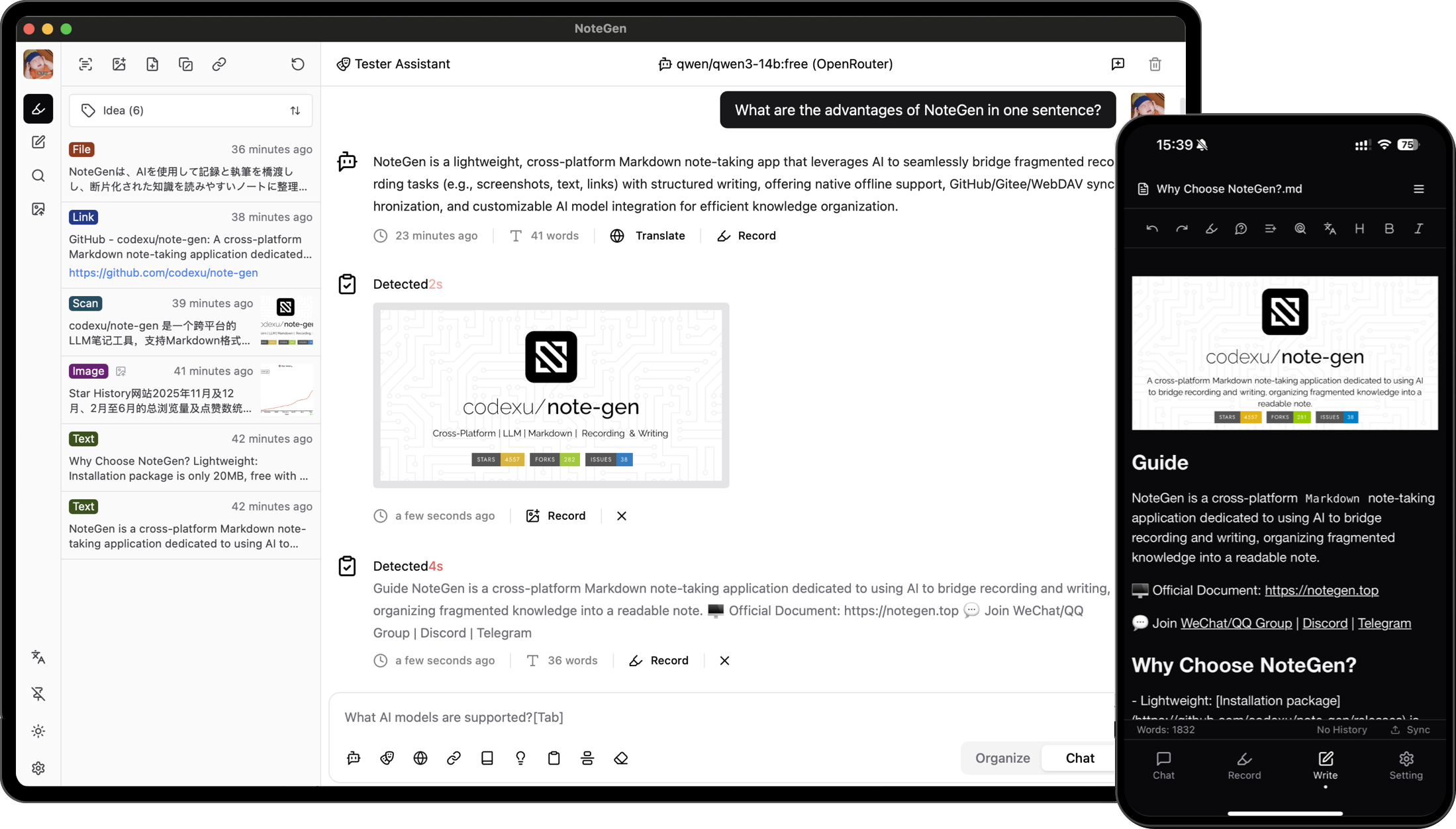

- Markdown笔记系统:提供Markdown格式的笔记功能,用户可以将与AI的对话或重要回复直接保存为笔记,便于管理和查阅。

- 一键运行模型:简化了本地模型的下载和配置过程,用户无需复杂的终端操作即可使用。

- 跨平台支持:基于Electron和TypeScript构建,确保在不同桌面操作系统上都能使用。

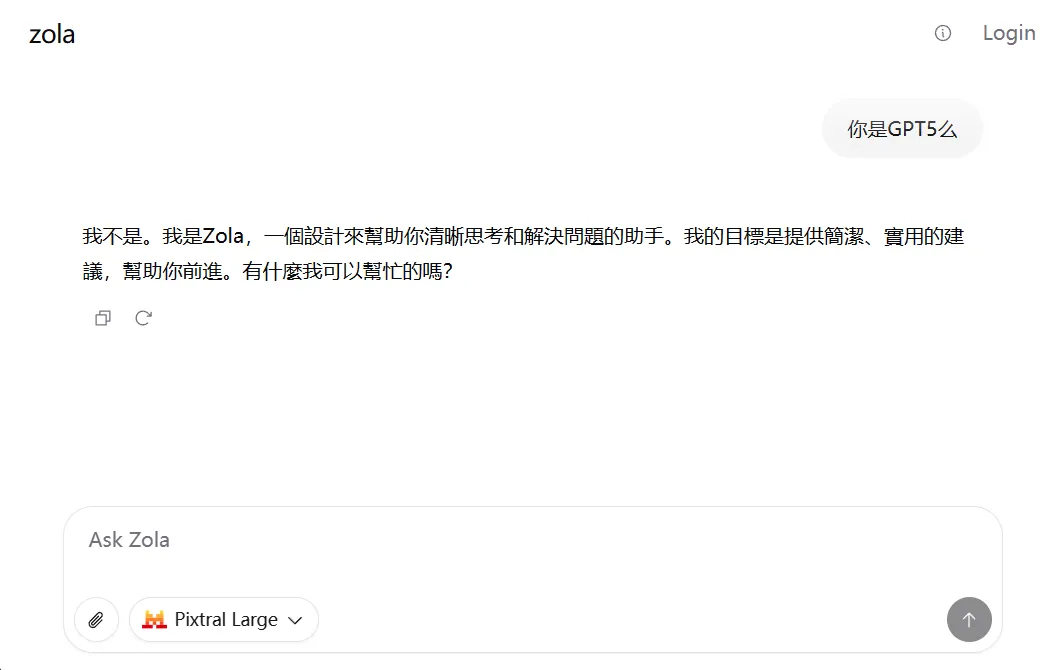

- 灵活的运行模式:除了完全本地的私有模式,也支持连接到Supabase、OpenAI和Anthropic等云端服务,使用如GPT-4o等更强大的模型。

- 文件与知识库管理:能够扫描、分析并总结单个文件乃至整个知识库,通过对话形式提供对内容的全面理解。

使用帮助

Klee是一款桌面应用程序,旨在让用户能够安全、本地化地使用AI功能。以下是安装和使用Klee的详细步骤,帮助你快速上手。

系统要求

在开始安装之前,请确保你的系统满足以下条件:

Node.js(版本 20.x 或更高)Yarn(版本 1.22.19 或更高)

安装流程

用户可以选择直接从官方网站 kleedesktop.com 下载已发布的版本,也可以通过源代码进行本地开发和部署。

步骤1:克隆客户端代码库

首先,你需要从GitHub上克隆Klee的客户端源代码。打开终端(Terminal)并输入以下命令:

git clone https://github.com/signerlabs/klee-client.git

然后进入项目目录:

cd klee-client

步骤2:安装依赖

在项目根目录下,使用Yarn来安装所有必需的依赖包:

yarn install

步骤3:配置环境变量

Klee使用环境变量来配置其运行模式和外部服务连接。你需要将示例环境文件复制一份并重命名为 .env。

cp .env.example .env

接下来,用文本编辑器打开 .env 文件,根据你的需求修改以下变量:

VITE_USE_SUPABASE: 设置为'false'将启用完全本地模式(默认),这是保护隐私的最佳选择。如果需要使用云端同步功能,则设为'true'。VITE_SUPABASE_ANON_KEY和VITE_SUPABASE_URL: 如果你启用了Supabase,需要在这里填写你自己的Supabase项目密钥和URL。VITE_OLLAMA_BASE_URL: 指定Ollama服务的地址。如果你在本地运行Ollama,默认地址通常是http://localhost:11434。VITE_REQUEST_PREFIX_URL: 指定Klee后端服务的地址,默认为http://localhost:6190。

步骤4:设置后端服务

Klee的前端应用需要一个后端服务(klee-service)来处理本地文件和执行RAG功能。你需要单独克隆并运行该服务。

打开一个新的终端窗口,执行以下命令:

git clone https://github.com/signerlabs/klee-service.git

cd klee-service

根据 klee-service 代码库中的 README.md 文件指引完成其安装和启动。请确保后端服务在.env文件中指定的端口(默认为 6190)上运行,以便客户端能成功连接。

步骤5:运行开发模式

当后端服务成功运行后,回到 klee-client 的终端窗口,运行以下命令来启动Klee桌面应用:

yarn dev

此命令会同时启动Vite开发服务器和Electron应用程序。

如何操作核心功能

1. 本地运行语言模型

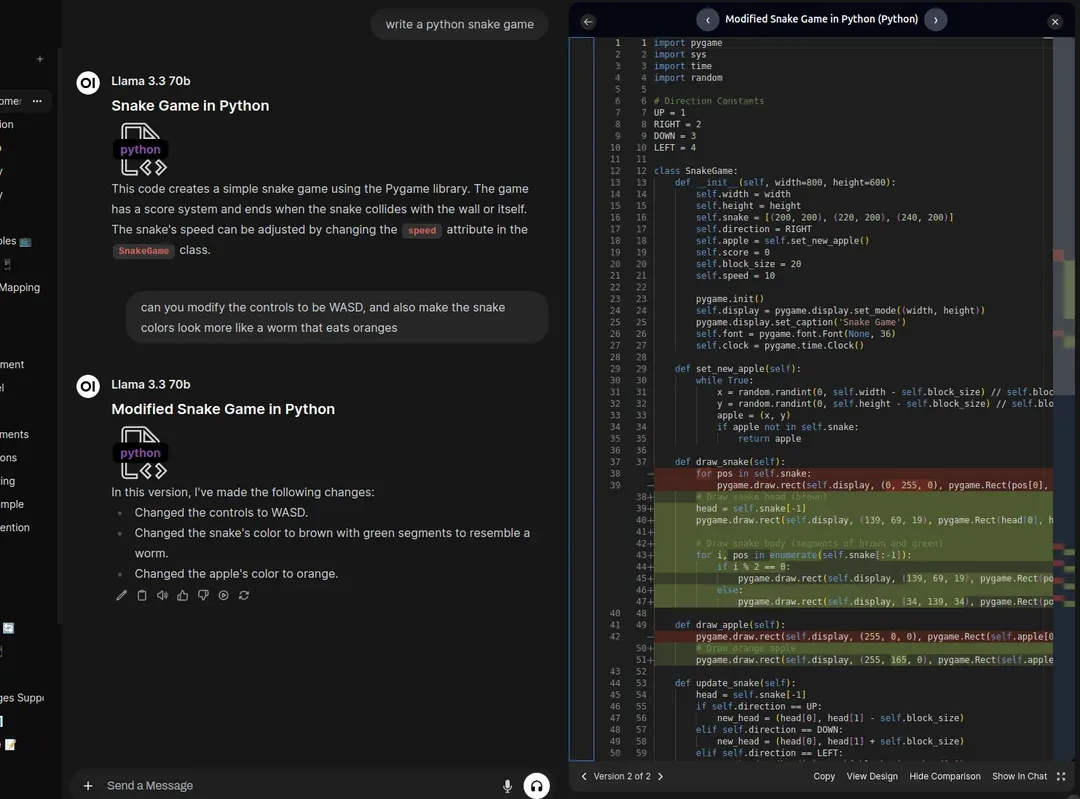

Klee通过与Ollama集成,极大地简化了本地大模型的使用。

- 下载模型:在Klee应用内,你可以浏览支持的开源模型列表(如Llama 3, Mistral等),并一键下载。

- 选择模型:在对话界面,你可以从已下载的模型列表中轻松切换,以适应不同的任务需求。

- 开始对话:选择模型后,直接在输入框中提问即可。所有的计算都在你的本地设备上完成。

2. 使用RAG知识库

这是Klee的特色功能,它让AI能够理解你的本地文件内容。

- 创建知识库:在Klee的知识库管理界面,你可以创建一个新的知识库,并为其命名。

- 添加文件:点击“添加文件”或“添加文件夹”,选择你希望AI学习的本地文档(如PDF、TXT、Markdown等)。Klee的后端服务会对这些文件进行处理和索引。

- 基于知识库提问:在对话时,你可以选择一个或多个知识库。此时,AI的回答将会基于这些文档中的信息,而不是其通用的知识。这对于处理私人报告、研究资料或个人笔记非常有用。

3. Markdown笔记功能

你可以轻松地将AI的回复或自己的想法整理成笔记。

- 保存对话:在与AI的每一次互动后,旁边通常会有一个保存或复制按钮,让你能快速将有价值的回答存入笔记。

- 创建和编辑笔记:在笔记区域,你可以创建新的Markdown文件。编辑器支持所有标准的Markdown语法,如标题、列表、代码块等。

- 管理笔记:所有笔记都以文件形式存储,你可以方便地进行组织、搜索和修改。

应用场景

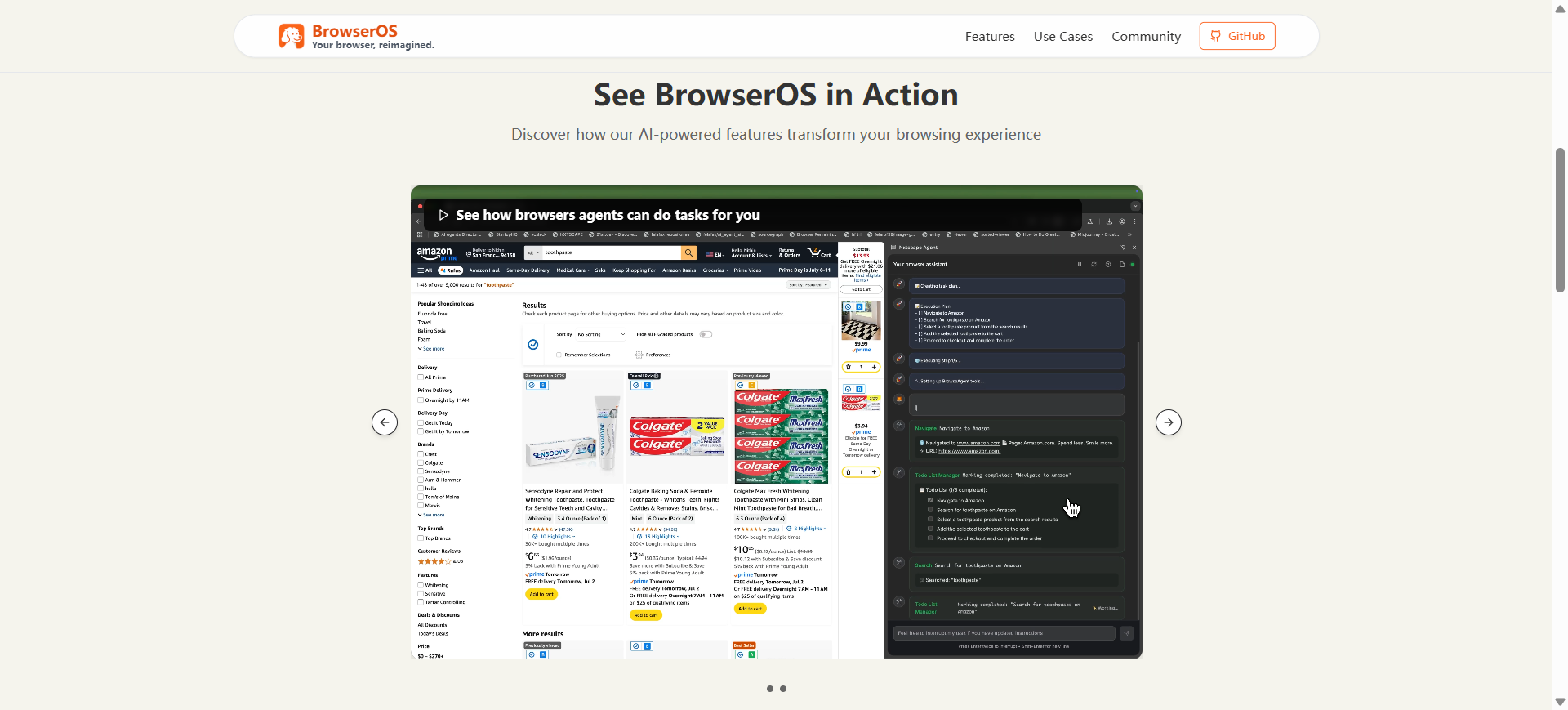

- 个人知识管理用户可以将本地的电子书、文章、研究报告和个人笔记添加到Klee的知识库中。当需要查找特定信息或对已有材料进行总结时,可以直接向AI提问。例如,你可以问:“根据我上传的关于气候变化的论文,总结一下主要的论点是什么?”

- 注重隐私的日常AI助手对于关心数据隐私的用户,Klee提供了一个安全的替代方案。你可以用它来起草邮件、编写代码、翻译文本或进行头脑风暴,而不用担心你的输入内容被发送到云端服务器。

- 开发者辅助工具开发者可以将项目的技术文档、API参考和代码规范添加到知识库中。在开发过程中,可以直接向Klee提问关于特定函数用法或项目架构的问题,AI会根据你提供的文档给出精准的回答。

- 无网络环境下的内容创作在飞机上、偏远地区或其他无法连接互联网的环境中,用户依然可以利用Klee的本地AI模型进行写作、分析和查询。由于模型和数据都在本地,创作过程不会中断。

QA

- Klee是否完全免费?对于个人用户,在本地模式下使用是终身免费的,包括无限次的AI模型对话、笔记和知识库条目。 针对团队协作和企业部署的商业版本未来可能会收费。

- 我的数据是否安全?是的。在默认的本地模式下,Klee不会将你的任何数据发送到互联网。所有的模型运算、文件处理和对话记录都存储在你的个人电脑上,确保了最高级别的隐私安全。

- Klee支持哪些操作系统?Klee的客户端是基于Electron技术构建的,理论上可以支持macOS、Windows和Linux。同时,社区也提到了专门为macOS优化的原生版本,以提供更好的性能体验。

- 我可以使用自己的语言模型吗?是的。Klee通过Ollama来管理和运行模型,Ollama支持从Hugging Face等平台导入多种开源模型。你可以在Ollama中配置好模型后,在Klee中进行调用。

- Klee和同类应用(如LM Studio)有什么区别?Klee不仅是一个模型运行工具,它深度整合了RAG知识库和Markdown笔记功能,形成了一个“对话-处理-记录”的闭环工作流。它的目标是成为一个完整的、以知识管理为核心的AI桌面助手,而不仅仅是模型的启动器。